подключаем AI к нашему synology

Я использовал свою систему запущенную на Ollama (Nvidia RTX4090), по производительности просадок нет. Как поднять на debian ollama расписывать не стану, сразу перейду к настройке совместной работы с synology.

Для начала на м надо сделать модель, которую сможет вызывать synology, для этого я склонировал Qwen/Qwen3-235B-A22B в gpt-4o-mini

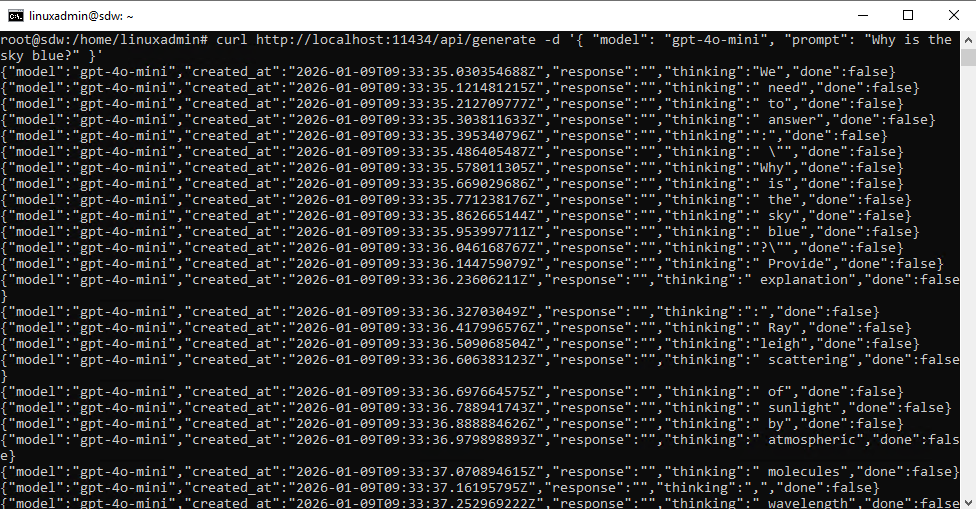

echo "FROM qwen3:235b" >> gpt-4o-mini.Modelfileollama create gpt-4o-mini -f ./gpt-4o-mini.Modelfileпроверка работы

curl http://localhost:11434/api/generate -d '{ "model": "gpt-4o-mini", "prompt": "Why is the sky blue?" }'

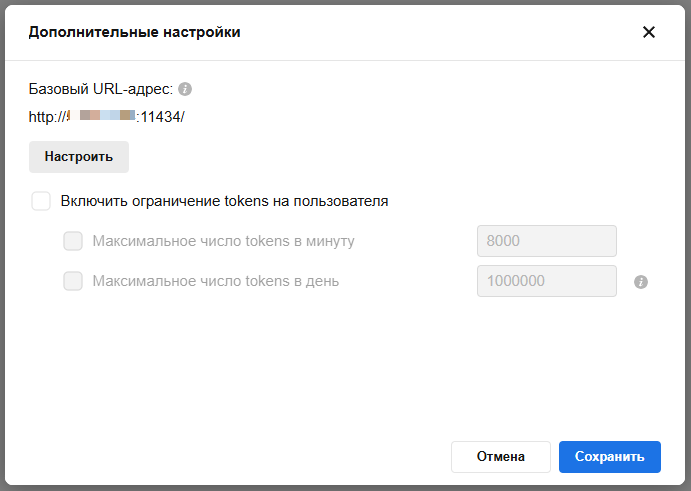

URL по-умолчанию для подключения к локальной Ollama http://ip_нашего_сервера:11434

формат API идентичный OpenAI

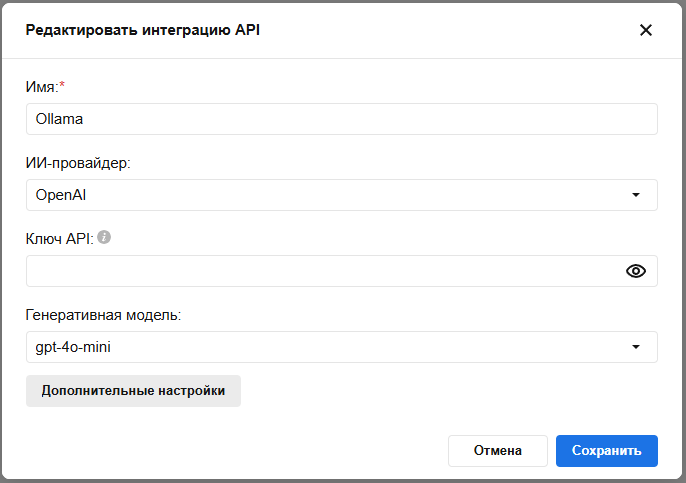

теперь в Synology добавляем новую LLM

название указываем своё, ключ API — любой (можно пробел)

открываем «Дополнительные настройки» и прописываем нашу URL

готово